Können Large Language Models (LLMs) wie ChatGPT die Befragung von Menschen ausreichend gut simulieren? Ein genauerer Blick auf Bedeutung und Funktion natürlicher Sprache bei Menschen und Maschinen kann darauf eine Antwort geben.

Kürzlich wurde ich um ein „Experteninterview“ für eine Masterarbeit gebeten, um über das Thema „Silicon Sampling im Marketing“ aus der psychologischen Perspektive zu sprechen. Unter Silicon Sampling versteht man synthetische, d.h. künstlich durch ein LLM (Large Language Model) erzeugte Befragte oder Befragungsdaten.

Es geht dabei nicht um die Frage, ob Maschinen wie Menschen denken, oder gar Bewusstsein entwickeln – da sind sich inzwischen die meisten Experten einig, dass dies nicht der Fall ist oder jemals möglich sein wird, zumindest nicht mit der heute verwendeten Technologie. Vielmehr geht es um die Frage, ob rein mit den mathematischen Prozeduren in Transformer-Modellen wie LLMs ausreichend gute Resultate als Ersatz für die Befragung von Menschen erzielt werden können, z.B. im Kontext von Marktforschung oder Nutzertests.

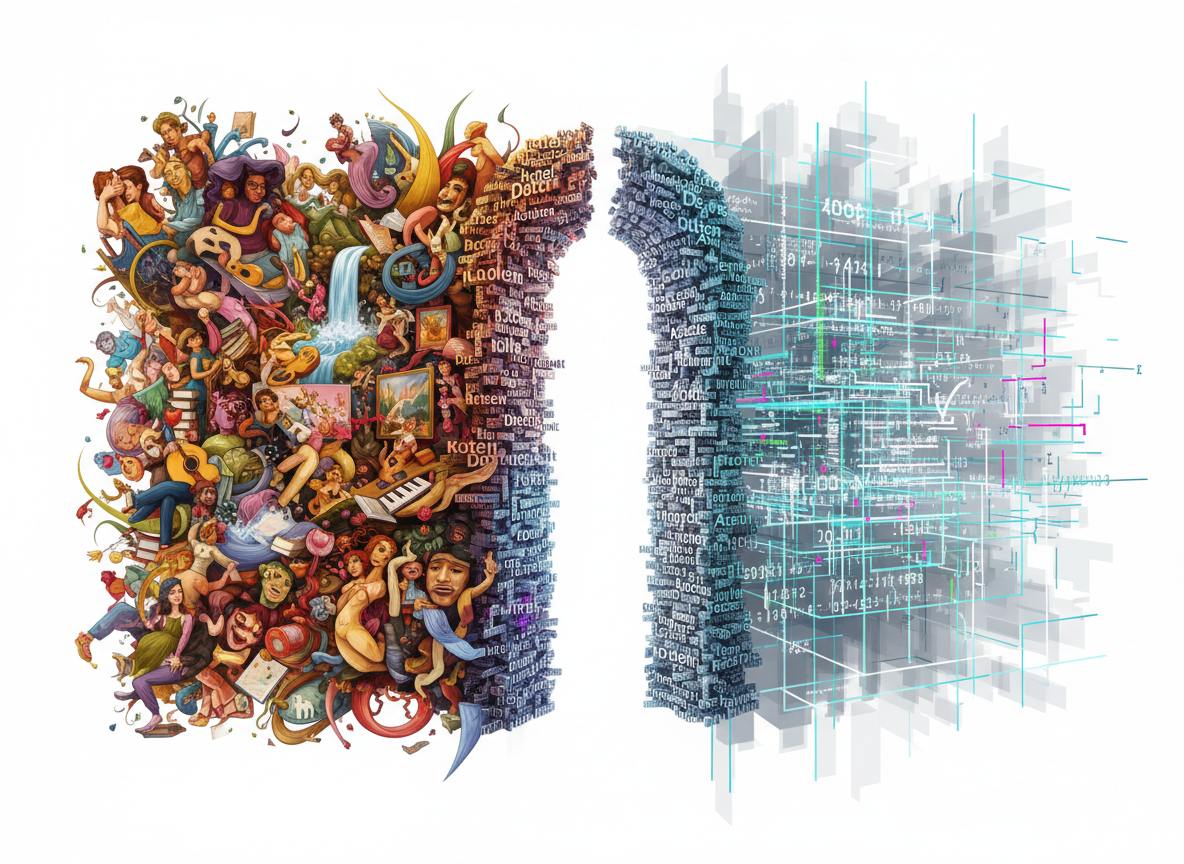

LLMs scheinen sich zunächst anzubieten, menschliches Antwortverhalten zu simulieren: Sie verwenden natürliche Sprache, und ihre Formulierungen wirken oft erstaunlich plausibel. Mensch und Maschine „treffen“ sich gewissermaßen im Interface „natürliche Sprache“. Daher lohnt zunächst ein Blick darauf, welche Funktion Sprache für Menschen hat, und welche für ein LLM, und wie sie jeweils unterschiedlich „verarbeitet“ wird.

Der Mensch und die Sprache

Menschen generieren keinen Sprachoutput. Sie kommunizieren. Sie nutzen Sprache als Mittel zum Austausch, um eine gemeinsame Sicht mit anderen auf die Welt herzustellen (selbst dann, wenn wir alleine sind, denken wir Andere quasi ‚hinzu’). Dabei ist die zur Verständigung ausgehandelte Sprache mit ihren Wörtern und ihrer Grammatik nur eines von vielen Mitteln, denn wir kommunizieren auch über den Körper und den kompletten sozialen und materialen Kontext. Das Regelwerk der Sprache alleine wäre viel zu limitiert.

In der Kommunikation verweisen wir grundsätzlich auf Vor- und Nichtsprachliches, auf unser körperliches In-der-Welt-Sein, unsere Beziehung zur Welt und zu anderen Menschen, auf unsere Intentionen und Motivation, unsere situativen Zustände und atmosphärischen Anmutungen, zudem schwingt immer ganz viel Unbewusstes mit. Gegenstand unserer Kommunikation ist daher nicht die Sprache selbst, sie ist nur eines von vielen Medien, um uns mit anderen zu synchronisieren.

Beim Verstehen von Sprache legen wir das Gehörte oder Gelesene (und viele weitere Hinweise aus dem Kontext) wiederum entsprechend unserer Sicht auf die Welt und unserer Erwartungen aus. Das können wir, weil wir selbst körperlich in der Welt verankert sind und viele vor- und nichtsprachliche Lebenserfahrungen mit unseren Kommunikationspartnern teilen.

Die Maschine und die Sprache

Für die Maschine ist das Interface Sprache etwas anderes. Sie kommuniziert nicht. Sie sagt das wahrscheinlichste nächste Wort auf Basis von hochkomplexen Textmustern voraus und verbleibt damit zu 100% auf der Ebene der Daten, die in der Sprache als Sprache enthalten sind. Sie verweist assoziativ auf andere Sprach-Bestandteile in hochdimensionalen Vektorräumen, nicht aber auf nicht-sprachliche, z.B. körperliche oder atmosphärische Erfahrungen.

Wir selbst sind es dann wieder, die Sinn und Bedeutung im maschinellen Output zu erkennen glauben (und verwechseln ihn mit ‘Kommunikation über etwas’), auch wenn er für die Maschine auf nichts außerhalb der nackten Wörter verweist. Solche Projektionen führen dazu, dass Menschen ein LLM sogar als persönlichen Coach oder Therapeuten nutzen können (sie behandeln sich dann quasi selbst wie in einem Spiegel). Mit echter Therapie hat dies natürlich nichts zu tun.

Ein LLM ist damit ein mächtiges Instrument zur Analyse und Vorhersage von Textmustern. Blind bleibt es hingegen für den Sinn und die Bedeutungen, die Menschen damit zum Ausdruck bringen wollen und auf die sie verweisen, wenn sie mit anderen kommunizieren.

Diese menschliche Ebene steckt gerade nicht in den riesigen Textbibliotheken, mit denen das LLM gefüttert wurde, denn unser ‘Innerstes’ sedimentiert sich nur zu einem sehr kleinen Teil irgendwann in Sprache oder Text (oder landet gar im Internet, wo sie LLMs trainieren kann), und dann auch i.d.R. in hochverarbeiteter Form.

Sie lässt sich auch nicht hinzu-trainieren, denn vieles lässt sich überhaupt nicht in Textform verarbeiten, wie leiblich verspürte Atmosphären oder unser im Körper gespeichertes knowing-how wie z.B. Klavierspielen oder Fahrradfahren. Vieles können Menschen nicht mal sagen. Vieles (und für die Psychologie oft das Entscheidende) ist schlicht unsagbar, und manches auch nur hilflos unbestimmt.

Kohlenstoff versus Mathematik

Dennoch wirkt der sprachliche Output oft echt und menschlich und erklimmt immer neue Höchstwerte auf der Turing-Test-Skala. Könnte es daher nicht völlig ausreichen, auf der rein textlich-statistischen Ebene Muster zu erkennen und vorherzusagen?

Die Antwort liegt auch hier in der unterschiedlichen Behandlung von Sprache. Die Maschine ahmt nach, was auf sprachlicher Ebene das Erwartbarste wäre. Das erzeugt eine hohe Plausibilität, gerade weil KI in der Logik von Statistik und Wahrscheinlichkeiten operiert. So kann sogar rein statistisch mögliches menschliches (Sprach-)Verhalten manchmal gut simuliert werden, aus Zufall, oder wenn die Aufgabe sehr nah an den Vorlagen im Trainingsmaterial liegt.

Bei neuartigen Aufgaben oder Situationen (dies ist in Forschungsprojekten in der Regel der Fall) produziert das LLM aber genauso lediglich statistisch wahrscheinliche und damit plausibel klingende Text-Fortsetzungen. Dies kann manchmal dem ähneln, wie ein Mensch geantwortet hätte, muss es aber nicht, auch wenn es so klingt, als ob. Hinzu kommt, dass ein synthetisches Befragungs-Ergebnis nicht reproduzierbar ist. Auch bei identischen Prompts liefert ein LLM je nach Modellversion, Systemprompts, individuellen Einstellungen oder internen Zufallsprozessen unterschiedliche Antworten. Diese Variation ist psychologisch nicht erklärbar, sondern hat technische Gründe.

Es gibt den schönen Begriff „Bullshit“. Bullshit wird definiert als etwas, das zwar plausibel daherkommt, bei dem es aber egal ist, ob es wahr ist oder nicht. Es lässt sich nie entscheiden, ob etwas eine gute Simulation ist oder einfach Unsinn. Das ist die Krux mit dem Bullshit.

Fazit

Als Psychologe sollte man jedenfalls eine gesunde Skepsis behalten, wenn “Silicon Sampling” als ersthafte Alternative für die Befragung von Menschen gehandelt wird. Wenn ich herausfinden möchte, wie Menschen denken und fühlen und warum sie zu einem bestimmten Schluss kommen, reicht es nicht, dass etwas so klingt, als würden Menschen es sagen.

Ich kann das LLM sicher dennoch gebrauchen, z.B. für eine erste Hypothesengenerierung, wenn etwa das Thema schon einmal in ähnlicher Form untersucht und veröffentlicht wurde, oder wenn ich einen ersten Eindruck erhalten möchte, wie sich eine bestimmte Zielgruppe anhören könnte. Dann ist es aber eine Ergänzung, und mir ist klar, dass es sich um die Konfabulation einer Maschine handelt, die auf Analysen von veröffentlichten Texten basiert.

Das kann enorm hilfreich sein. Es simuliert aber weder ausreichend gut noch zuverlässig genug Befragungen von Menschen, und – das ist wichtig für den Diskurs – dies wird es auch nicht mit immer besseren oder spezieller trainierten Modellen tun, weil dadurch nur die textliche Plausibilität weiter erhöht, nicht aber Erleben und Verhalten brauchbarer simuliert wird.

(ms)

Ergänzungen und Anmerkungen:

* Das Beitragsbild wurde dem Thema entsprechend (hier im Blog ausnahmsweise) komplett mit KI erstellt (ich glaube, es war dieses Gemini-Banana)

** Dass sich die Trainingsdaten der LLMs immer auf die Vergangenheit beziehen, wurde mir deutlich, als ich ChatGPT vor dem Interview gefragt hatte, was denn unter “Silicon Sampling im Marketing” zu verstehen sei. Die Antwort: “Es handelt sich bei Silicon Sampling um Produktmuster in Mini- oder Dummyform, die aussehen wie echte elektronische Geräte, aber oft nicht funktional sind. Sie dienen als haptische, visuelle oder demonstrative Muster, bevor ein Produkt wirklich fertig entwickelt oder produziert ist. Der Begriff kommt daher, dass diese Muster oft aus Silikon, Kunststoff oder 3D-Druck bestehen – also „Silicon“ als Material, nicht Silizium (Halbleiter)”. ChatGPT 5.1 muss mit dem Training schon fertig gewesen sein, bevor der Begriff seinen Weg ins Netz gefunden hat. Klingt aber trotzdem plausibel.